Microsoft Fabric ist eine Software-as-a-Service (SaaS) Plattform für die unternehmensweite Datennutzung. In einer einheitlichen Oberfläche werden alle Funktionen für die Bereiche Datenintegration, Data Engineering, Business Intelligence, Data Science und Real-Time Analytics zusammengefasst. Somit wird die Zusammenarbeit aller Datenexperten verbessert um noch effizienter Informationen aus Daten gewinnen zu können.

Die Fabric Komponenten

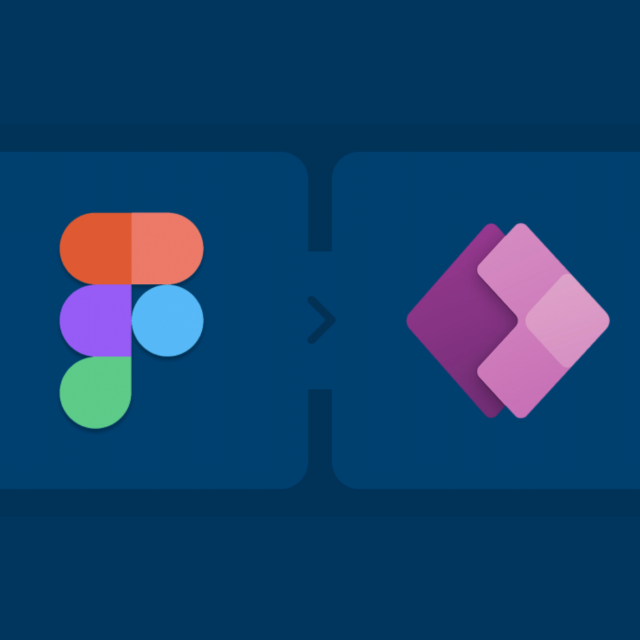

In Microsoft Fabric stehen für jeden Anwendungsbereich darauf ausgerichtete Komponenten bereit. Für Datenvisualisierung und Berichtserstellung beispielsweise, wurde Power BI integriert. Die Datenbewirtschaftung wiederum wird mit Komponenten aus Data Factory umgesetzt. Möchten Sie Datenströme in Echtzeit sammeln und auswerten, bietet Fabric dafür Werkzeuge aus Synapse Real Time Analytics. Anwendungen bei denen automatisierte Aktionen anhand bestimmter Datenmuster getriggert werden sollen, können mit den Werkzeugen des Data Activators umgesetzt werden. Für die Mustererkennung oder der statistischen Aufbereitung von Daten, sowie das Erstellen von Machine Learning Modellen bietet Fabric Lösungen aus Synapse Data Science.

Die Grundalge für das reibungslose Zusammenspiel aller Komponenten bildet die zentrale Datenbasis OneLake. Damit wird eine nahtlose Integration und Verwaltung aller Daten Ihres Unternehmens ermöglicht, die zu Auswertungs- und Analysezwecke bestimmt sind. Mit Purview können Sie Ihre Daten im OneLake klassifizieren und katalogisieren. Darüber hinaus stellt Purview sicher, dass alle Daten im OneLake Ihren Sicherheits- und Compliance-Anforderungen entsprechen.

Alle Fabric Komponenten arbeiten nahtlos mit Copilot zusammen. Somit können Sie durch die KI Berichte oder Data Pipelines erstellen lassen. Darüber hinaus ermöglicht Copilot Abfragen in natürlicher Sprache zu formulieren. Dies erleichtert den Zugang zu Datenanalysen und macht sie auch für weniger technisch versierte Benutzer zugängig.

Diese einzelnen Komponenten sind bereits in der Azure-Welt ausreichend etabliert und werden in Fabric anwenderfreundlich und gebündelt zur Verfügung gestellt.

OneLake – Das OneDrive für Ihre Daten

OneLake ist die zentrale Komponente von Microsoft Fabric, die speziell für die Verwaltung und Analyse großer Datenmengen entwickelt wurde. Microsoft spricht dabei vom OneDrive für Ihre Daten. Der Vergleich hebt die intuitive und einfache Administration der Datenhaltung hervor.

Im OneLake können strukturierte und unstrukturierte Daten jeglichen Formats gespeichert werden. Dabei werden die Daten im Delta-Parquet-Format abgelegt, dass speziell auf die Anforderungen von analytischen Systemen ausgerichtet ist. Zum einen werden die Daten effizient komprimiert, des Weiteren werden wiederkehrende Datenaktualisierungen vereinfacht, da nur die geänderten Daten verarbeitet werden.

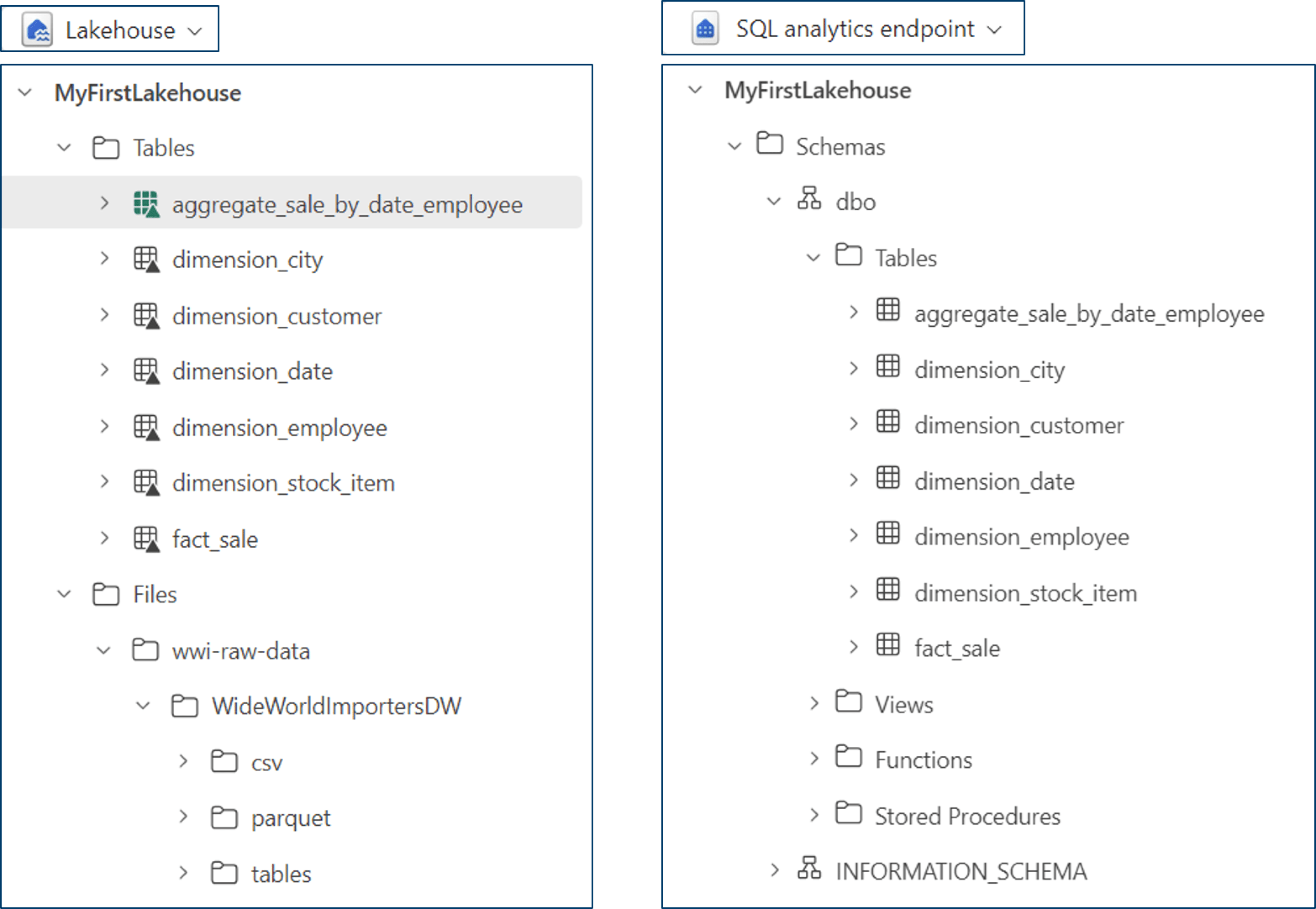

Einstiegspunkt für das OneLake ist das Lakehouse.

Ihre Daten werden in der Explorer Ansicht in strukturierten Tabellen und unstrukturierten Dateien angezeigt. Für strukturierte Daten bietet das Lakehouse einen zusätzlichen SQL Endpoint. Somit können Sie beispielsweise importierte csv-Dateien ohne zusätzliche Transformation per SQL abfragen oder weiter verarbeiten.

Zusätzlich lassen sich Daten über Cloud- und Domänen-Grenzen hinweg mit sogenannten Shortcuts virtuell im OneLake verfügbar machen.

Mit Hilfe des OneLake Clients können Sie Daten bequem zwischen ihrem Rechner und OneLake austauschen. Die Bedienung des Clients ist mit der von OneDrive vergleichbar.

Daten mit Data Factory integrieren

Data Factory in Microsoft Fabric bietet eine Vielzahl von Vorteilen, die es zu einer leistungsstarken Lösung für Datenintegration und -transformation machen.

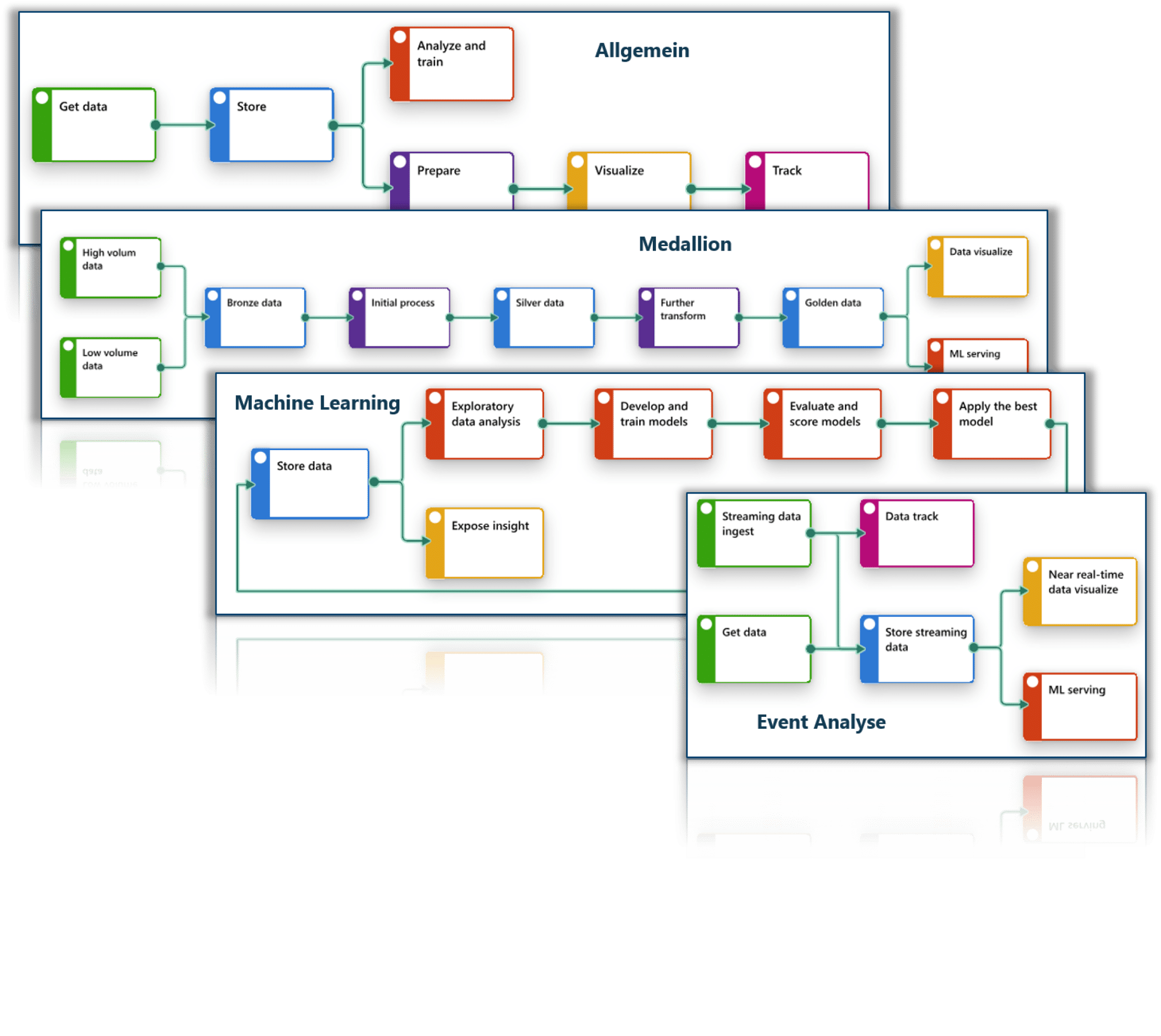

Für einen einfachen Einstieg bietet Fabric Templates für wiederkehrende Szenarien der Datenintegration:

Darüber hinaus können mit Data Factory alle Aufgaben der Datenintegration abgebildet werden:

- Schneller Datenimport: Der einfachste Weg, Daten in Ihr OneLake zu integrieren ist die Funktion “Fast Copy”

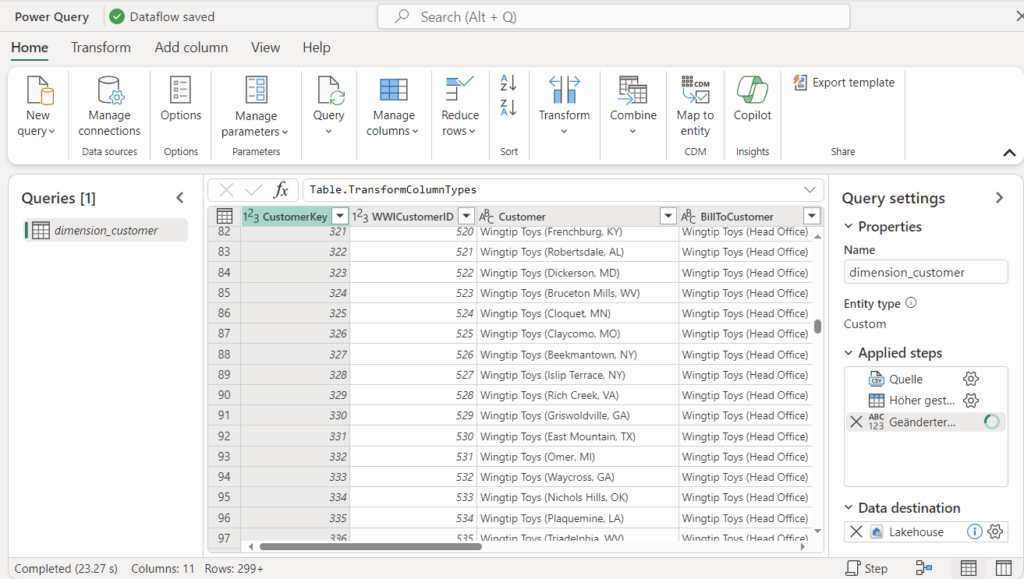

- Umfangreiche Transformationen: Dataflows ist ein einfaches No Code / Low Code Datenintegrations-Tool. Dabei werden über 170 Konnektoren für die Anbindung jeglicher Datenquellen und über 300 Transformationen, einschließlich KI-basierter Datentransformationen, unterstützt. Mit Datenpipelines können komplexe Datenworkflows erstellt und orchestriert werden, die den spezifischen Anforderungen Ihres Unternehmens entsprechen.

- Spiegelung und Replikation: Fabric bietet die Möglichkeit Datenbanken per Spiegelung nach OneLake zu replizieren. Bisher werden kostenfreie Spiegelungen für SQL-Datenbanken, Cosmos-Datenbanken und Databricks-Kataloge unterstützt.

- Automatisierung und Planung: Pipelines können so eingerichtet werden, dass sie automatisch zu bestimmten Zeiten oder als Reaktion auf bestimmte Ereignisse ausgeführt werden.

Unterstützung durch Künstliche Intelligenz

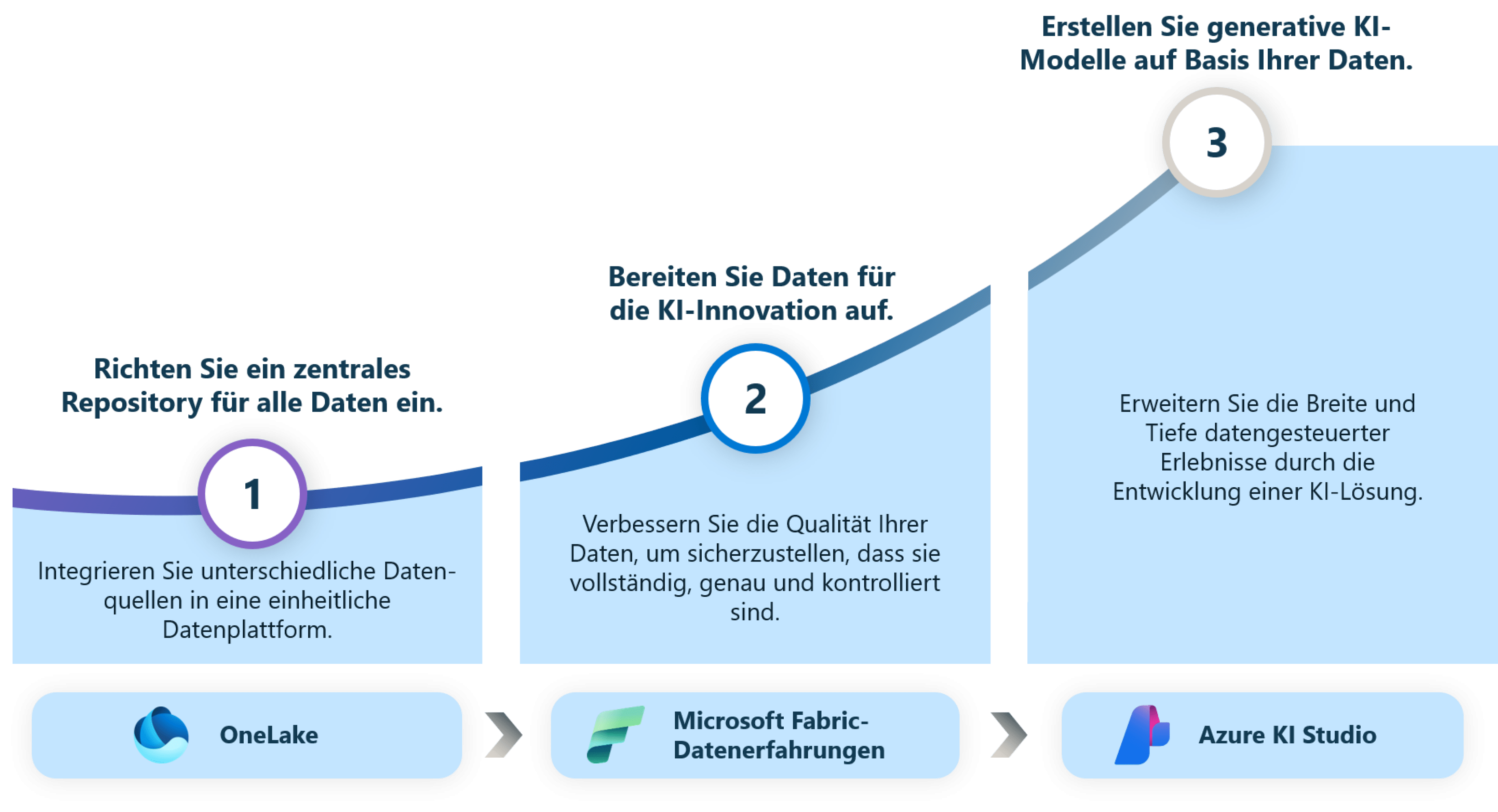

Fabric ist darauf ausgelegt, Ihnen die Nutzung von Künstlicher Intelligenz (KI) der nächsten Generation für Ihre Daten zu ermöglichen. Das beginnt mit der Integration von Copilot in jede Komponente um Ihre Produktivität zu steigern und Ihnen bei der Erschließung Ihrer Daten zu helfen. Darüber hinaus ermöglicht Ihnen Fabric die nahtlose Nutzung von Azure OpenAI-Modellen und AI-Plug-Ins, um KI-Modelle für Ihre Daten und Ihr Unternehmen bereitzustellen.

Mit Copilot in Microsoft Fabric können Sie natürliche Sprache verwenden, um Dataflows, Pipelines oder Power BI Berichte zu erstellen, SQL-Anweisungen zu schreiben oder sogar Modelle für maschinelles Lernen zu generieren. Per Chat artikulieren Sie Ihre Anforderungen, die von Copilot sekundenschnell umgesetzt werden.

Wenn Sie in Data Engineering oder Data Science in einem Notebook arbeiten, können Sie Ihre Daten schneller anreichern, modellieren, analysieren und erkunden. Durch Copilot können Sie Muster in Ihren Daten, statistische Zusammenhänge erkennen oder durch Predictive Analysis zukünftige Szenarien bewerten. Damit hilft KI helfen, Ihr Unternehmen besser zu verstehen und die Lücke zwischen Erkenntnissen und Maßnahmen zu schließen.

Die Nutzung von Copilot für Fabric ist ab einer F64 Kapazität lizensiert.

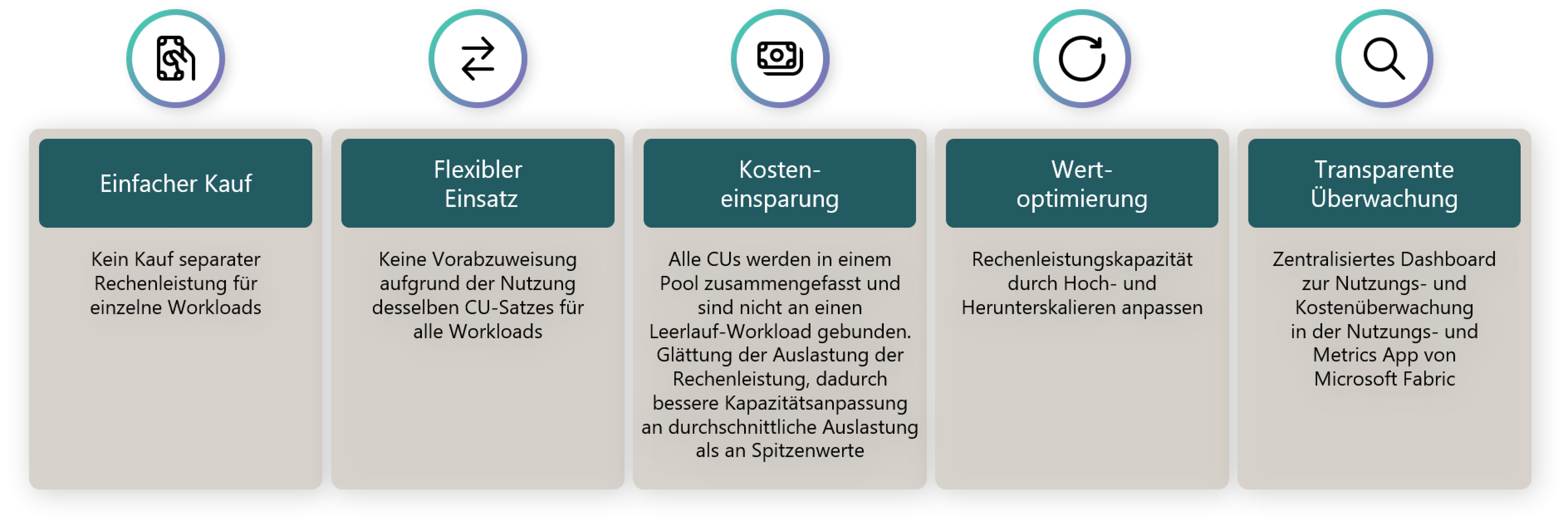

Das Microsoft Fabric Lizenzmodell

Im Gegensatz zu den Azure Diensten, ist Microsoft bestrebt die Lizensierung für Fabric so einfach wie möglich zu gestalten um Einstiegshürden zu reduzieren. Die Bereitstellung aller Fabric-Komponenten erfolgt über Kapazitäten. Eine Kapazität (Capacity Units, CUs) bündelt Rechenleistung (Compute) und Speicher (Storage) für Data Warehouse, Data Integration, Data Science, Data Engineering, Real-Time Analytics, Power BI, Data Activator und Copilot. Damit wird der Entscheidungsprozess für die optimale Ausstattung vereinfacht.

Warum Microsoft Fabric?

Durch Microsoft Fabric können alle Analyseanforderungen Ihres Unternehmens umgesetzt werden. Das Schlagwort heißt „Integration“. Mitarbeiter:innen können funktionsübergreifend auf den selben Datenbestand zugreifen. Insofern bietet Fabric folgende Vorteile:

- End-to-End-Datenplattform: Microsoft Fabric bietet eine umfassende Lösung, die alle Aspekte der Datenverarbeitung abdeckt, von der Datenintegration und -verarbeitung bis hin zur Echtzeitanalyse und Berichterstellung.

- Nahtlose Integration: Fabric integriert etablierte Komponenten in einer einheitlichen Umgebung und einheitlicher Oberfläche. Dies erleichtert die Verwaltung und Nutzung von Daten erheblich.

- Zentralisierte Datenspeicherung: Mit OneLake bietet Fabric eine zentrale Speicherlösung was die Konsistenz und Verfügbarkeit der Daten sicherstellt.

- Sicherheit und Governance: Fabric ermöglicht die Anwendung von Sicherheits- und Governance-Richtlinien. Dies erleichtert die Einhaltung von Datenschutzbestimmungen und erhöht die Sicherheit der Daten.

- KI-Integration: Fabric verfügt über eingebaute KI-Funktionen, die die Datenverarbeitung und -analyse beschleunigen und vereinfachen.

- Flexibles Lizenzmodell: Das Lizenzmodell von Fabric ist flexibel und ermöglicht eine kapazitätsbasierte Abrechnung, die minutengenau erfolgt und keine langfristigen Verpflichtungen erfordert.

Diese Merkmale machen Microsoft Fabric zu einer leistungsstarken und vielseitigen Plattform für moderne Daten- und Analyseanforderungen.